Jorge Baquerizo -Burgos ID· María Egas-Izquierdo ID· Doménica Cunto ID· Carlos Robles-Medranda ID

Departamento de Endoscopia, Instituto Ecuatoriano de Enfermedades Digestivas (IECED), Guayaquil, Ecuador.

Acta Gastroenterol Latinoam 2023;53(3):211-225

Recibido: 09/08/2023 / Aceptado: 14/09/2023 / Publicado online el 29/09/2023 / https://doi.org/10.52787/agl.v53i3.339

Resumen

La inteligencia artificial es un campo de la ciencia y la ingeniería que se ocupa de la comprensión computacional de comportamientos inteligentes y la creación de artefactos que exhiben tales comportamientos, lo que permite a las computadoras funcionar y pensar de manera similar a la de los seres humanos. Esta tecnología ayuda a superar los múltiples retos que enfrentan los profesionales de la salud y aporta al diagnóstico, al manejo y al pronóstico de los pacientes. Actualmente se están desarrollando varios modelos para la endoscopia digestiva, incluyendo algunos que permiten la detección de estructuras anatómicas que pueden ayudar en el entrenamiento de los médicos, servir como guía durante los procedimientos endoscópicos o para la estratificación de lesiones premalignas y malignas. De esta forma disminuirían los falsos negativos y se proporcionarían más tratamientos oportunos. En la actualidad existen sistemas computarizados de detección de lesiones y de diagnóstico en los distintos segmentos de la vía digestiva, cada uno con funciones particulares que proporcionan asistencia durante los procedimientos. Todo esto se ha llevado a cabo con el fin de reducir los riesgos derivados de los factores humanos y ambientales, entre otros, los cuales pueden afectar el diagnóstico y el manejo de las enfermedades. Los modelos de inteligencia artificial en la endoscopia digestiva pueden, además de mejorar la impresión visual de los endoscopistas, disminuir la curva de aprendizaje a través de la aplicación de tecnologías precisas. De esta manera, se reduce la diferencia entre los endoscopistas expertos y menos expertos. En este artículo se discuten los avances tecnológicos de la inteligencia artificial en la endoscopia digestiva y los aspectos futuros relacionados.

Palabras claves. Inteligencia artificial, detección asistida por computadora, diagnóstico asistido por computadora, aprendizaje profundo, endoscopia.

The Era of Intelligent Endoscopy: How Artificial Intelligence Empowers Digestive Endoscopy

Summary

Artificial intelligence is a field of science and engineering that focuses on the computational understanding of intelligent behaviors and the creation of artifacts that exhibit such behaviors, enabling computers to function and think similarly to humans. This technology assists in overcoming the various challenges that healthcare professionals face, contributing to the diagnosis, management, and prognosis of patients. Currently, several artificial intelligence models have been developed in the field of digestive endoscopy, including some that enable the detection of anatomical structures that can aid in the training of medical professionals, serve as guides during endoscopic procedures, or assist in stratifying pre-malignant and malignant lesions. This reduces false negatives, providing timely treatments. Computerized lesion detection and diagnostic system exist for different segments of the digestive tract, each with specific functions that provide assistance during procedures. All of this has been done with the aim of reducing risks stemming from human and environmental factors, among others, which can affect early diagnosis and management of diseases. Artificial intelligence models for digestive endoscopy can not only enhance the visual impression for endoscopists but also reduce the learning curve through the application of precise technologies, thus bridging the gap between experienced and less experienced endoscopists. This article discusses the technological advancements of artificial intelligence in digestive endoscopy and related future aspects.

Keywords. Artificial intelligence, Computer-assisted detection, computer-assisted diagnosis, deep learning, endoscopy.

Abreviaturas

IA: Inteligencia artificial.

ML: Machine learning (aprendizaje de máquinas).

DL: Deep learning (aprendizaje profundo).

CADe: Computer-assisted detection device (dispositivo de detección asistida por computadora).

CADx: Computer-assisted diagnostic device (dispositivo de diagnóstico asistido por computadora).

EUS: Endoscopic ultrasound (ultrasonido endoscópico).

EGD: Esofagogastroduodenoscopia.

AUC: Area under the curve (área bajo la curva).

EB: Esófago de Barrett.

NBI: Narrow Band Imaging (imágenes de banda estrecha).

ERGE: Enfermedad por reflujo gastroesofágico.

SVM: Support Vector Machine (máquinas de vector en soporte).

CNN: Convolutional Neural Network (red neuronal convolucional).

CCR: Cáncer colorrectal.

RR: Riesgo relativo.

PDR: Polyp Detection Rate (tasa de detección de pólipos).

CPRE: Colangiopancreatografía endoscópica retrógrada.

VPP: Valor predictivo positivo.

VPN: Valor predictivo negativo.

mAP: Mean Average Precision (media de precisión).

FPS: Frames per Second (fotogramas por segundo).

NPMI: Neoplasia papilar mucinosa intraductal.

GIST: Gastrointestinal Stromal Tumors (tumores del estroma gastrointestinal).

Introducción

Inteligencia artificial: conceptos básicos

La inteligencia artificial (IA) es una rama de las ciencias de la computación cuyo ejecución de comprensiones inteligentes a partir de un conjunto de modelos.1 Usando un conjunto de algoritmos, la IA es capaz de funcionar y pensar como un ser humano mediante un proceso de aprendizaje basado en el entrenamiento y tiene como ventaja el poder completarlo en menor tiempo que el ser humano.1 Adicionalmente, esta tecnología puede integrar el aprendizaje de máquinas (machine learning, ML) y una rama de éste, el aprendizaje profundo (deep learning, DL).2

El ML es un subgrupo de la IA que se caracteriza por la utilización de modelos matemáticos para el aprendizaje de datos que posteriormente permitirán el reconocimiento de patrones.3 A partir de los algoritmos se crean modelos predictivos que permiten el análisis de datos y la resolución de problemas complejos. Asimismo, el ML puede ser supervisado, no supervisado y de reforzamiento:2,4,5

• El aprendizaje supervisado está basado en el entrenamiento a partir de datos bien categorizados o etiquetados (supervisión externa). Los datos etiquetados son divididos para el entrenamiento y la validación interna. Este tipo de aprendizaje está basado en la regresión, la clasificación y la caracterización.2,3

• El aprendizaje no supervisado o automatizado es el modelo que aprende de datos no categorizados y que permite al algoritmo actuar sin ningún tipo de guía, basándose en el entendimiento de patrones y, por ende, requiriendo mayor cantidad de información.2,3

• El aprendizaje de reforzamiento no requiere datos ni supervisión para alimentarse sino que está basado en el aprendizaje del entorno a partir de recompensas.2,3

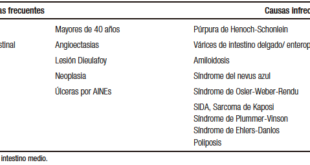

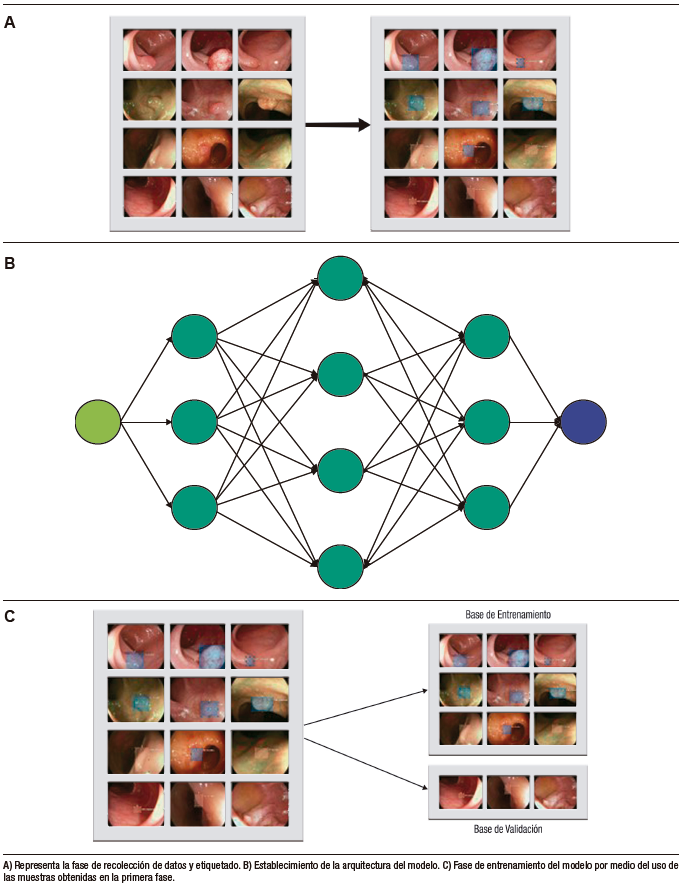

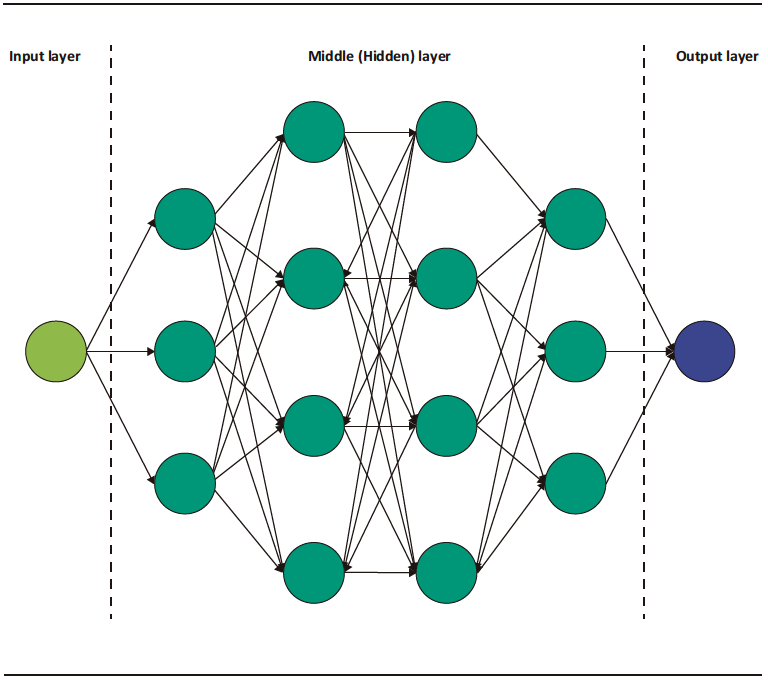

El DL es una categoría especial del ML, el cual está basado en la arquitectura de redes neuronales análogas a las del cerebro humano.3 Consiste en una capa inicial que recibe una entrada o input; a esta capa la sigue un conjunto de capas medias ocultas o hidden layers y, a continuación, la capa final de salida u output (Figura 1). Cada capa de esta red consiste en un grupo de neuronas o nodos que convierten (activación) un input en output a partir de funciones matemáticas.2 El output de una capa anterior sirve de input para la capa siguiente, y así sucesivamente, hasta llegar a la capa de salida y obtener un resultado o detección.2,3

Figura 1. Representación esquemática de la arquitectura de los modelos de redes neuronales convolucionales

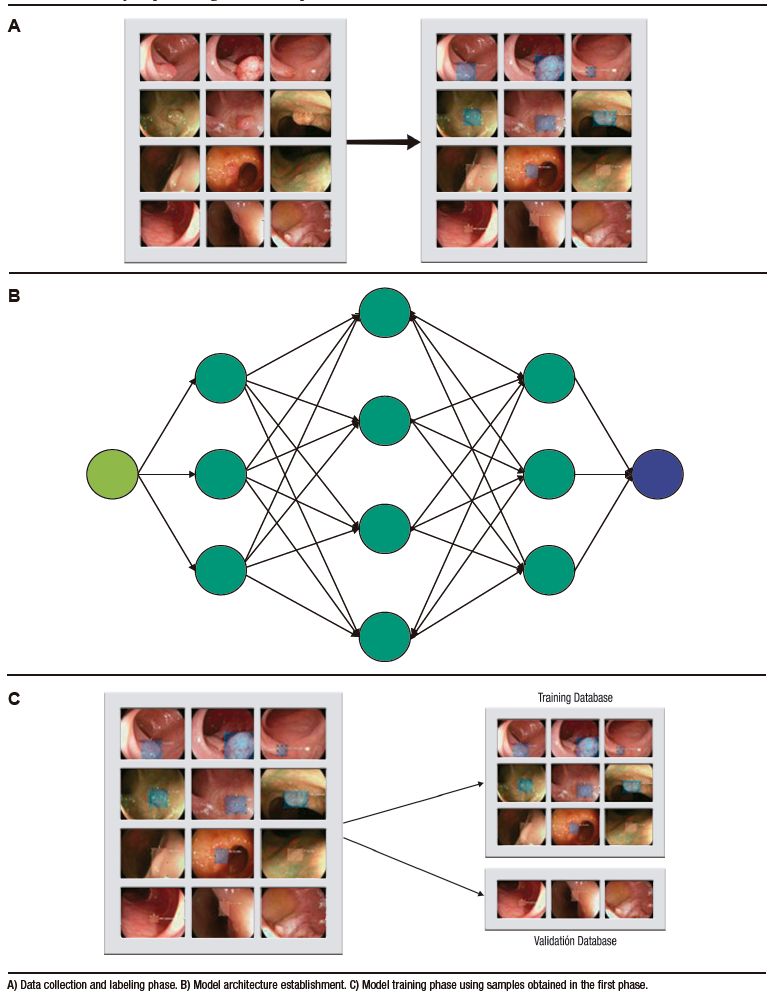

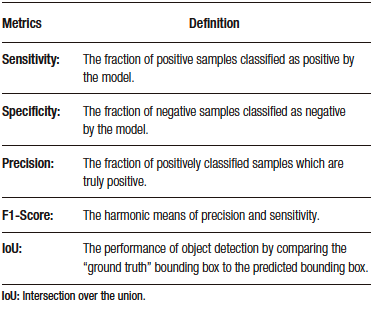

El desarrollo del modelo de detección basado en DL incluye tres fases principales. En la primera fase, se realiza la recolección de datos (imágenes o videos) y se etiquetan adecuadamente las estructuras que se utilizarán en el aprendizaje del modelo. Luego, en la segunda fase, se establece la arquitectura del modelo y se crean las redes neuronales (capa de entrada, capas medias y capa de salida). Finalmente, en la tercera fase, se utilizan las muestras obtenidas en las fases anteriores para realizar el entrenamiento del modelo y su subsecuente validación interna (Figura 2).1 De esta última fase se obtienen las métricas para la evaluación del rendimiento del modelo (Tabla 1).

Figura 2. Fases de desarrollo de modelos de aprendizaje profundo

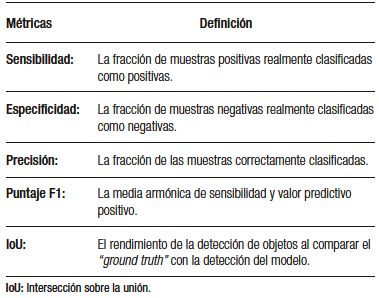

Tabla 1. Métricas obtenidas para evaluación del rendimiento de los modelos de aprendizaje profundo

Aplicaciones clínicas de la inteligencia artificial

Las aplicaciones clínicas de la IA han aumentado progresivamente en el área de la salud, incluida la gastroenterología. La IA ayuda a superar los múltiples retos que enfrentan los profesionales de la salud durante la adquisición, el análisis y la aplicación de conocimientos que aportan al diagnóstico, al manejo y al pronóstico de los pacientes.1 Además, la automatización en la identificación y el reconocimiento de imágenes ayudan a la reducción de errores derivados de factores humanos (fatiga, carga laboral, entre otros).

El avance tecnológico ha permitido la realización de sistemas inteligentes que facilitan la detección o la estratificación de lesiones observadas durante procedimientos endoscópicos o imagenológicos. Estos se denominan dispositivos de detección asistida por computadora (Computer-assisted detection device, CADe) o de diagnóstico asistido por computadora (Computer-assisted diagnostic device, CADx).6 De esta manera, la aplicación de estos dispositivos en la endoscopia digestiva puede facilitar y aumentar la detección de lesiones durante los procedimientos y categorizar lesiones en benignas y malignas en tiempo real.

Inteligencia artificial en la endoscopia digestiva

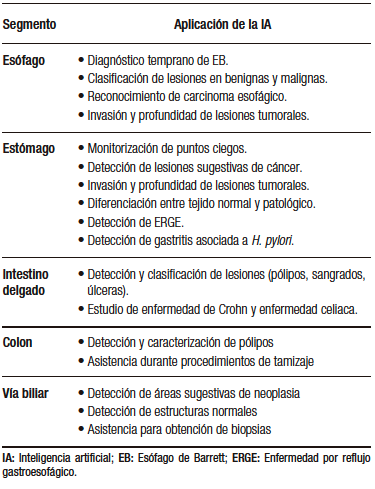

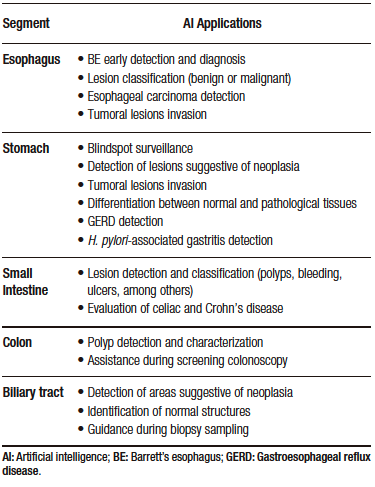

Actualmente se están desarrollando varios modelos para la endoscopia digestiva alta y baja, y para procedimientos endoscópicos avanzados (colangioscopia y ultrasonido endoscópico, EUS) (Tabla 2). Estos modelos incluyen CADe y CADx con algoritmos característicos que permiten distintas funcionalidades como detectar estructuras anatómicas y lesiones específicas, ayudar en el entrenamiento de los médicos, servir como guía durante los procedimientos endoscópicos, reducir el número de falsos negativos por medio de la caracterización y la estratificación de lesiones premalignas y malignas, entre otras.4

En los siguientes apartados se revisará información actualizada sobre los usos de la IA y su repercusión de acuerdo con el tipo de evaluación endoscópica.

Tabla 2. Aplicaciones de la inteligencia artificial en los distintos segmentos de la vía digestiva

Endoscopia digestiva alta

También conocida como esofagogastroduodenoscopia (EGD), es un procedimiento de gran importancia en el diagnóstico de las lesiones del tracto gastrointestinal superior.7,8 Sin embargo, la tasa de diagnóstico varía según el desempeño de cada endoscopista.9 Los errores durante la realización de la EGD son una de las principales causas en el fallo del diagnóstico de lesiones premalignas y de enfermedades esofagogastroduodenales severas. Los sistemas de IA han sido desarrollados para sobrepasar las barreras técnicas antes descritas. Su aplicación en el tracto digestivo superior va desde la localización anatómica hasta la detección y la evaluación de lesiones malignas y premalignas.7-10

Takiyama et al. desarrollaron un modelo de IA capaz de clasificar las estructuras anatómicas del tracto digestivo superior, el cual ha mostrado un buen desempeño durante la identificación de la laringe (AUC 1,00), el esófago (AUC 1,00), el estómago (superior, medio e inferior) y el duodeno (AUC 0,99).7

Por otro lado, en el estudio multicéntrico realizado por Luo et al. se evalúo la precisión diagnóstica del modelo GRADIS para la detección de neoplasias del tubo digestivo superior (esófago y estómago). Este modelo alcanzó una precisión diagnóstica del 95,5% (IC 95%: 95,2 – 95,7) durante la validación interna. Al comparar su desempeño con el de los endoscopistas que tenían diferentes niveles de experiencia, la sensibilidad fue similar a la de los expertos (94,2% versus 94,5%) y mayor al compararla con los endoscopistas competentes (94,2% versus 85,8%) y los endoscopistas en entrenamiento (94,2% versus 72,2%).11 Adicionalmente, la precisión diagnóstica de los expertos (92,8%) al usar el modelo de IA fue similar al grupo de endoscopistas competentes (93,4%) y endoscopistas en entrenamiento (90,4%).11 Esto demuestra que la aplicación de IA disminuye la brecha entre expertos y no expertos.11

Esófago

La precisión en el diagnóstico temprano del esófago de Barrett (EB) y de la neoplasia esofágica continúa siendo un reto incluso para muchos endoscopistas experimentados. Una vez identificado el EB, es necesaria la identificación de las regiones con displasia o adenocarcinoma temprano.

Los modelos de IA han sido designados con el fin de ayudar a los endoscopistas a mejorar la precisión en el diagnóstico de las lesiones mencionadas,12 e incluyen sistemas para la clasificación de las neoplasias que aplican la magnificación en vivo con alta precisión (89,9%). Esto ha permitido el diagnóstico y la diferenciación tempranos de neoplasia en el EB.13,14

El CADx desarrollado y validado por De Groof et al. permitió la clasificación de imágenes neoplásicas y no neoplásicas en el EB comparándola con el desempeño de 53 endoscopistas. El modelo superó el desempeño de los endoscopistas y obtuvo mayor precisión (88% versus 73%), sensibilidad (93% versus 72%) y especificidad (83% versus 74%).15

Por otro lado, debido a la gran importancia en el reconocimiento y el tratamiento oportuno del carcinoma de esófago, los investigadores han desarrollado sistemas que permiten la detección de las lesiones, así como también la invasión de la enfermedad.12,16,17 El carcinoma esofágico suele ser detectado en estadios tardíos, y las lesiones pequeñas suelen ser detectadas por endoscopistas muy experimentados.12 La IA permite la detección de lesiones menores de 10 mm con una gran precisión (91,4%), incluso mayor que muchos endoscopistas denominados expertos (> 15 años; 88,8%), con moderada experiencia (5 – 15 años; 81,6%), y baja experiencia (< 5 años; 77,2 %).16

La determinación de la profundidad de la lesión permite la selección del tratamiento (quirúrgico, endoscópico, farmacológico) y la determinación del pronóstico.17 Uno de los modelos con gran exactitud diagnóstica en la predicción de la profundidad de la invasión del carcinoma escamoso del esófago es el propuesto por Tokai et al.

Los investigadores utilizaron 1751 imágenes para el entrenamiento y 291 para la validación; se obtuvo una sensibilidad del 84,1% y una exactitud diagnóstica del 80,9% en la estimación de la profundidad de la invasión del carcinoma. A su vez, al comparar el modelo con trece endoscopistas éste obtuvo mayor exactitud diagnóstica y mayor AUC.17

Estómago

El cáncer de estómago suele presentar síntomas inespecíficos durante sus estadios tempranos; debido a esto los pacientes suelen ser diagnosticados en estadios avanzados. El pronóstico del cáncer de estómago depende de la valoración de la profundidad y de la detección temprana de las lesiones. Se ha reportado que la detección temprana del cáncer de estómago puede aumentar la supervivencia a los 5 años a un 90%.18

De acuerdo con Menon et al., la tasa de falsos negativos en el diagnóstico de cáncer de estómago temprano puede alcanzar el 25%.18 Los sistemas de automatización buscan disminuir este porcentaje con modelos que clasifiquen las imágenes del estómago en la EGD para monitorear puntos ciegos con gran precisión,19 modelos que detecten lesiones sugestivas de cáncer de estómago11 y lesiones precancerosas,20 y que además evalúen la profundidad de la invasión.21

La cromoendoscopia es uno de los métodos diagnósticos utilizados para la detección temprana de neoplasia gástrica. Sin embargo, durante una sesión endoscópica se pueden generar múltiples fotogramas de videos (frames) que convierten la revisión de ésta en una labor exhaustiva para los endoscopistas.

Para evitar pérdidas durante la evaluación, Ali et al. desarrollaron un CADx entrenado para clasificar fotogramas normales y patológicos a partir de la textura local y global. Este mostró una sensibilidad, especificidad, precisión y AUC del 91%, 82%, 87% y 0,91%, respectivamente.22 El modelo demostró ser una ayuda diagnóstica durante la detección temprana del cáncer gástrico ya que reduce el tiempo utilizado para la evaluación de la secuencia endoscópica.

El modelo estudiado por Wu et al.19 obtuvo alta precisión, especificidad y sensibilidad (92,5%, 94% y 91%, respectivamente) en la evaluación de no malignidad y superó a los endoscopistas expertos en esta tarea.19 Adicionalmente, durante procedimientos en tiempo real mostró un gran rendimiento en la detección del adenocarcinoma gástrico temprano con monitorización de puntos ciegos. Junto a este, otros modelos de IA han mostrado una gran precisión durante el diagnóstico de la neoplasia gastrointestinal comparable con la de endoscopistas expertos.11,17

Por otro lado, se han desarrollado modelos que además de identificar las lesiones neoplásicas también predicen su profundidad. Nagao et al. entrenaron a un modelo para predecir la invasión en profundidad del cáncer gástrico utilizando imágenes convencionales de luz blanca, imágenes de banda estrecha (Narrow Band Imaging, NBI), e imágenes con contraste índigo carmín.21 El modelo demostró alta precisión basada en los tres sistemas (imágenes de luz blanca 94,5%, NBI 94,3% e índigo carmín 95,5%).21

Zhu et al. (precisión total 89,16%) y Yoon et al. (sensibilidad 81,7%, especificidad 75,4%) han reportado que la precisión diagnóstica de su modelo para evaluar la profundidad de la invasión es comparable con la de otros métodos convencionales. Las ventajas de utilizar estos modelos radican en la evaluación más objetiva de las características macroscópicas de las lesiones, con la disminución del uso de otras técnicas invasivas como el EUS.21,23,24

Además de la identificación de neoplasia, otras aplicaciones incluyen la detección de la enfermedad por reflujo gastroesofágico (ERGE)25 y de gastritis asociada a Helicobacter pylori.26 Modelos desarrollados para la asistencia durante la clasificación de la ERGE con NBI han alcanzado una precisión diagnóstica total del 99,2% para lesiones grado A-B, 100% para lesiones grado C-D y 100% en el grupo control. Por lo tanto, se consideran de gran utilidad para la asistencia durante la detección de lesiones compatibles con ERGE, y aumentan la precisión diagnóstica en endoscopistas en entrenamiento.25

Por otro lado, la red neuronal diseñada para la predicción de Helicobacter pylori en imágenes endoscópicas diagnosticó correctamente el 80% de los casos negativos, el 84% de los casos erradicados y el 48% de los casos positivos. Los autores de este estudio resaltan la utilidad de este modelo en la identificación de pacientes que requieran alguna prueba de confirmación de Helicobacter pylori a partir de los resultados endoscópicos, y recomiendan su uso como asistencia diagnóstica.26

Intestino delgado

La cápsula endoscópica, procedimiento no invasivo, permite la detección y la clasificación de lesiones (sangrado, úlceras y pólipos), la valoración de la motilidad intestinal y la evaluación de la enfermedad celíaca, entre otras patologías que afectan especialmente al intestino delgado. Sin embargo, la evaluación de la gran cantidad de imágenes obtenidas (> 60 000 imágenes) y la dificultad para el manejo direccional de la cápsula (dependiente totalmente de la peristalsis del tubo digestivo) hacen que el estudio sea prolongado (de 45 minutos a 8 horas) y tedioso. Para sobrellevar las dificultades técnicas derivadas de este procedimiento se ha buscado su automatización a partir de la IA.28

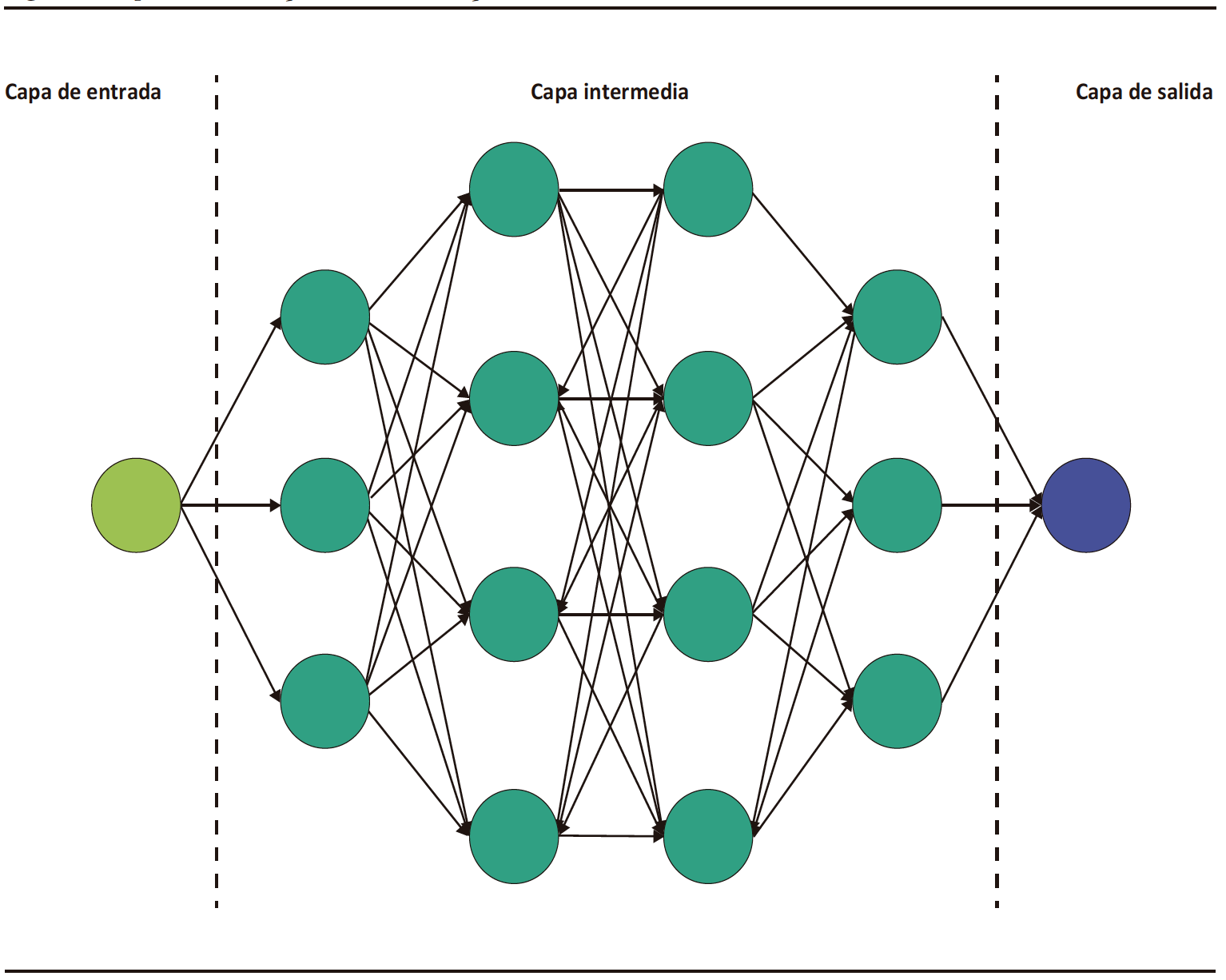

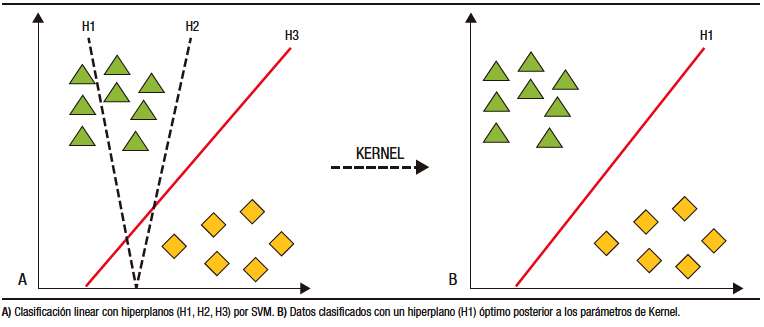

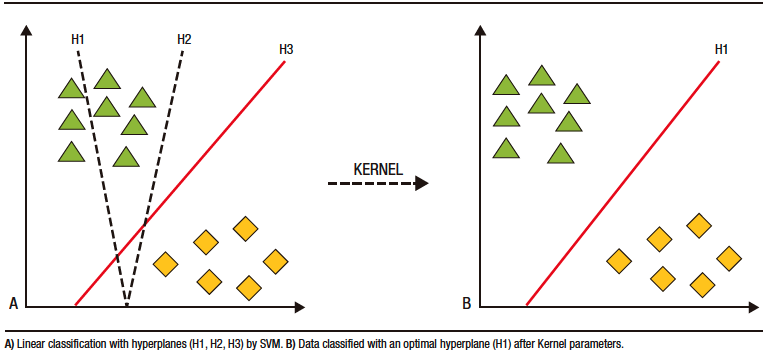

Los modelos de IA para cápsula endoscópica han basado su desarrollo en DL. La clasificación y categorización de las imágenes se realiza a partir de máquinas de vector en soporte (SVM, por sus siglas en inglés). Por medio de estos modelos, los datos son separados por hiperplanos de dos o más dimensiones. Luego de utilizar los parámetros de Kernel, se consigue el hiperplano «óptimo» que crea «fronteras» para la categorización de los datos (Figura 3).27,28 Posterior a la categorización se forman los algoritmos de DL que crean así las redes neuronales artificiales.27,29

Figura 3. Máquinas de vector en soporte (SVM) para clasificación de datos

Actualmente, los modelos de IA para cápsula endoscópica incluyen el seguimiento de la cápsula, la detección de pólipos, sangrado, úlceras, y el estudio de patologías propias del intestino delgado como la enfermedad celíaca y la enfermedad de Crohn.26

En general, en el tracto gastrointestinal, los modelos incorporados en la cápsula endoscópica permiten su seguimiento y localización en los distintos segmentos (boca, estómago, intestino delgado y colon), previa anulación de frames con «ruido» (heces, burbujas, entre otros) con una sensibilidad y especificidad > 88%.30 La evaluación de las imágenes de acuerdo con su localización topográfica ahorra tiempo de estudio y aumenta la precisión diagnóstica.30

En el estudio multicéntrico publicado por Ding et al.30 se desarrolló una red neural convolucional (CNN) para la identificación de imágenes normales, inflamación, úlceras, pólipos, linfangiectasias, sangrado, enfermedad vascular, divertículos y parásitos, entre otros. Al comparar los resultados del modelo de los gastroenterólogos participantes, se obtuvo una sensibilidad del 98,9% (IC 95%: 99,7-99,9) versus 74,6% (IC 95%: 73,1-76) en la identificación de anormalidades por paciente y una sensibilidad del 99,9% (IC 95%: 99,6 – 99,9) versus 76,9% (IC 95%: 75,6 – 78,2) en el análisis por lesión. Asimismo, el tiempo de lectura por paciente fue menor en el grupo de la CNN versus los gastroenterólogos (5,9 ± 2,23 minutos versus 96,6 ± 22,53 minutos, p < 0,001). A partir de estos resultados los investigadores concluyeron que la aplicación de la IA en la cápsula endoscópica es una herramienta importante para ayudar a los gastroenterólogos a analizar las imágenes capturadas con este dispositivo de manera más eficiente y precisa.31

Los modelos para la detección de sangrado en tiempo real alcanzan una precisión diagnóstica de hasta el 99%.32-34 El modelo de Aoki et al. detectó sangrado gastrointestinal con una sensibilidad, especificidad y precisión del 96,6%, 99,9% y 99,9%, respectivamente.31 Otros modelos desarrollados ayudan a la estratificación y predicción del riesgo de hemorragias recurrentes con el fin de brindar un tratamiento oportuno y evitar endoscopias innecesarias.35,36

Para la detección de úlceras y erosiones, el modelo de Wang et al. alcanzó una precisión diagnóstica del 92,1%.37 Para la identificación de tumores la precisión diagnóstica parte del 86%, con una sensibilidad que oscila entre el 88% y el 97%, y una especificidad entre el 81% y el 96%.38

En un metaanálisis reciente sobre la CNN en cápsulas endoscópicas, se obtuvo una sensibilidad agrupada y una especificidad del 96% (IC 95%: 91-98) y 97% (IC 95%: 93-99) en la detección de úlceras y erosiones; 97% (IC 95%: 93-99) y 100% (IC 95%: 99-100) en la identificación de sangrado gastrointestinal; 97% (IC 95%: 82-99) y 98% (IC 95%: 92-99) en la detección de cáncer y pólipos.37

Adicionalmente, los modelos desarrollados para la identificación de enfermedad inflamatoria intestinal por medio de cápsula endoscópica alcanzan en la actualidad altos niveles de precisión (83,3% al 90,8%)39 y permiten también el reconocimiento de patrones ocultos de la enfermedad.4

En comparación con los endoscopios actuales con los que se obtienen imágenes de muy alta calidad, la calidad de las imágenes de la cápsula endoscópica es baja.27 Sin embargo, los modelos de IA para la cápsula endoscópica tienen la ventaja de contar con una base de datos robusta, alimentada con una gran cantidad de imágenes útiles para la creación de la CNN.

Endoscopia digestiva baja

Intestino grueso

El cáncer colorrectal (CCR) se considera en la actualidad una de las principales causas de muerte relacionadas con el cáncer en hombres y mujeres.40 Para la identificación temprana de lesiones premalignas (pólipos y adenomas) la colonoscopia sigue siendo un estudio imprescindible. Sin embargo, de acuerdo con la literatura, se puede perder la identificación de aproximadamente el 25% de estas lesiones, incluso en manos expertas.41 Las lesiones premalignas no detectadas aumentan el riesgo de desarrollar CCR.

Para la detección y caracterización de los pólipos se han desarrollado sistemas automatizados. Los primeros sistemas desarrollados utilizaban una cantidad reducida de imágenes y tenían como consecuencia una precisión diagnóstica baja (72%).42 Posteriormente, se han entrenado nuevos modelos con mayor precisión (> 95%), que utilizan un mayor número de imágenes. Esto permite que en la actualidad se pueda evaluar mejor los pólipos y los adenomas diminutos (≤ 5 mm); y predecir el pronóstico del CCR, la supervivencia de los pacientes y la presencia de invasión a distancia.42,43

Un metaanálisis evaluó el rendimiento de los CADe en la detección de neoplasia colorrectal.44 Los autores obtuvieron mayor tasa de detección de adenomas (adenoma detection rate, ADR) en los grupos en los que se usaron los CADe en comparación con sus grupos control (36,6% versus 25,2%; RR: 1,44; IC 95%: 1,27-1,62; p < 0,01). Asimismo, la detección de adenomas por colonoscopia fue superior en los grupos en los que se usaron CADe en comparación con el grupo control (50,3% versus 34,6%; RR: 1,70; IC 95%: 1,53-1,89; p < 0.01). Los autores no evidenciaron una diferencia significativa en la eficiencia de la colonoscopia (tiempo de retirada) entre los grupos en que se usaron CADe y el grupo control.44

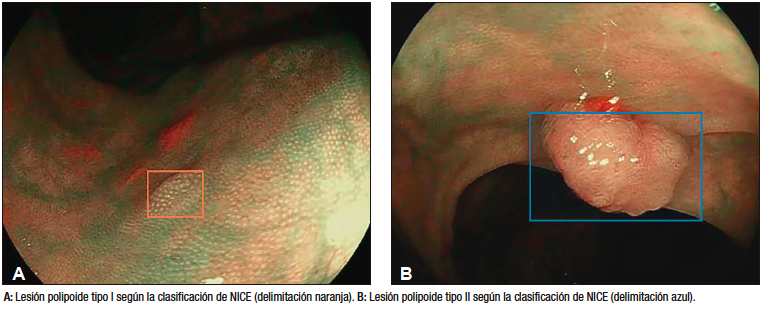

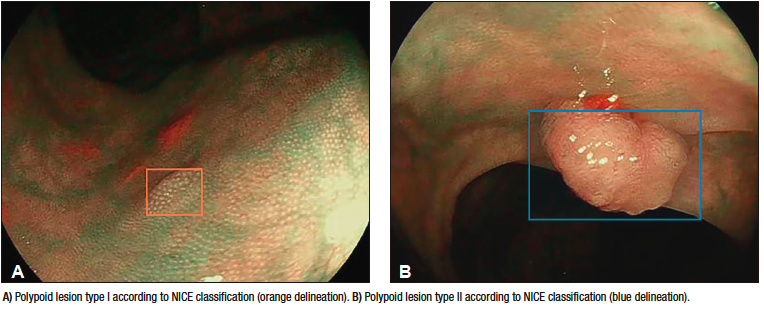

Robles-Medranda et al. estudiaron la eficiencia de la colonoscopia asistida por IA para la detección de pólipos y adenomas durante los estudios de screening de CCR (Figura 4).45 Los resultados obtenidos por los autores fueron comparados de acuerdo con el nivel de experiencia de los endoscopistas (expertos versus no expertos). Con la asistencia de la IA durante los procedimientos endoscópicos, se obtuvo un aumento de la ADR y tasa de detección de pólipos del 16,5% al 18,2% y del 50,4% al 60%, respectivamente. De acuerdo con el nivel de experiencia, el aumento de la ADR fue evidente en el grupo junior (10,8% a 16,2%), que se aproximó al nivel de los expertos.45

Figura 4. Detección de lesión polipoide en colon utilizando un dispositivo de detección asistido por computadora (CADe) (AITROL, mdconsgroup, Guayaquil, Ecuador)

Además, se han diseñado CADx con capacidad de caracterizar de manera inmediata los pólipos utilizando tecnología de imágenes más allá de la endoscopia con luz blanca y NBI magnificada, y la endomicroscopia confocal. En este campo, un modelo desarrollado por Sánchez-Montes et al. para la predicción de la clasificación histológica de los pólipos, alcanzó una precisión diagnóstica, una sensibilidad y una especificidad del 91,1%, 92,3%, y 89,2%, respectivamente.46

Adicionalmente, características como la depresión de la lesión, la convergencia de los pliegues, y el patrón capilar irregular y heterogéneo se asocian con la invasión en profundidad de las lesiones premalignas. Los modelos actuales de los CADe para la identificación de las características antes descritas resultan atractivos antes de determinar el tipo de tratamiento a realizar (por ejemplo, la resección endoscópica de la mucosa).4

Técnicas endoscópicas avanzadas

A pesar de que en la actualidad se encuentran disponibles algunos métodos diagnósticos, como colangioscopia, colangiopancreatografía endoscópica retrógrada (CPRE) o EUS para el estudio del sistema biliopancreático, existen dificultades en la diferenciación de lesiones y discrepancia entre los evaluadores.

Colangioscopia

Como la colangioscopia es una técnica endoscópica avanzada, relativamente nueva y sin guías de entrenamiento establecidas, la impresión visual entre los operadores es muy variable.47 Se han creado varias clasificaciones para detectar malignidad basándose en las características macroscópicas de las lesiones de la vía biliar durante el procedimiento,48-51 con la intención de disminuir esta variabilidad entre los observadores. Sin embargo, estas clasificaciones no han logrado ese objetivo.47

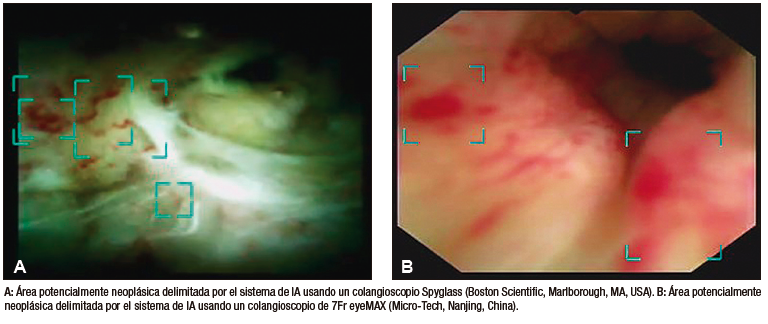

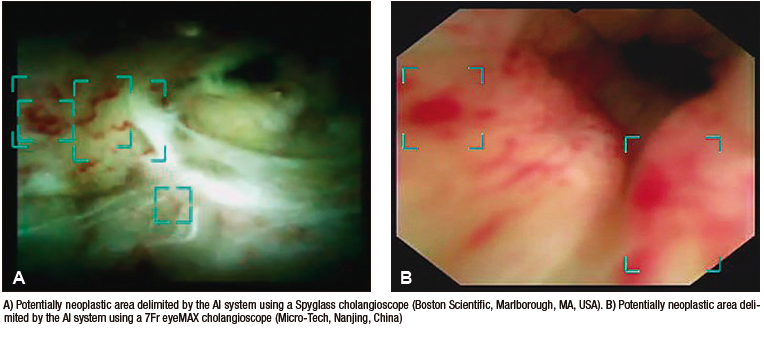

Recientemente, se han empezado a desarrollar modelos de IA con la finalidad de ayudar a los operadores a detectar lesiones malignas y a obtener biopsias. Los primeros modelos de IA en la colangioscopia fueron desarrollados para la detección de vasos sanguíneos tortuosos, pero tenían la desventaja de estar limitados a imágenes y no era posible su utilidad en casos en vivo.52,53 Otra limitación de dichos modelos es su falta de validación clínica. Sin embargo, obtuvieron métricas de validación interna bastante altas. En su primer estudio, Mascarenhas et al. desarrollaron un modelo con 6475 imágenes de colangioscopia obtenidas de 85 pacientes. Durante la validación con frames se obtuvo una sensibilidad, una especificidad, un valor predictivo positivo (VPP) y valor predictivo negativo (VPN) de 99,3%, 99,4%, 99,6% y 98,7%, respectivamente.53 Luego, desarrollaron un nuevo trabajo en el que duplicaron el número de imágenes obtenidas del mismo número de pacientes (de 6475 a 11855); esta vez evaluaron la precisión del modelo para distinguir entre lesiones benignas y malignas. Las métricas obtenidas fueron: precisión diagnóstica (94,9%), sensibilidad (94,7%), especificidad (92,1%), VPP (94,8%) y VPN (84,2%).52 Se resalta que a pesar de que el modelo obtuvo excelentes parámetros de validación interna, estos no deben ser extrapolados a su utilidad real en casos clínicos en vivo.

Posteriormente, se realizaron dos estudios con modelos de IA en tiempo real. El primer estudio, realizado por Marya et al., evalúa la aplicación clínica del modelo y lo compara con los resultados de las biopsias y la citología. En el estudio se observa que el modelo de CNN obtuvo mayores sensibilidad (93,3%), especificidad (88,2%) y precisión (90,6%) en comparación con las biopsias, que obtuvieron 35,7% de sensibilidad, 100% de especificidad y 60,9% de precisión; y con la citología, que obtuvo 40%, 100% y 62,5% de sensibilidad, de especificidad y de precisión, respectivamente.54 Una de las limitaciones del estudio fue que sólo un operador estuvo a cargo de realizar las anotaciones de alrededor de 2 millones de imágenes, lo que puede conllevar a errores por fatiga y a la aparición de un sesgo.

Robles-Medranda et al. desarrollaron su propio modelo de CNN capaz de detectar lesiones neoplásicas en videos pregrabados y en tiempo real (Figura 5). Posterior a las etapas de implementación de modelos de IA (recolección, anotación y diseño del modelo), se realizó la validación interna y luego una comparación clínica entre el modelo y los endoscopistas (expertos y no expertos).55 Este estudio multicéntrico se llevó a cabo en dos fases. La primera fase fue la de desarrollo y validación del modelo de IA, denominado AIworks-Cholangioscopy (mdconsgroup, Guayaquil, Ecuador). La primera versión de este modelo fue desarrollada a partir de 81080 imágenes de 23 pacientes, y obtuvo una media de precisión (mAP) de 0,298, un puntaje F1 de 0,280, la intersección sobre la unión fue de 32,3% y la pérdida total fue de 0,1034. A pesar de ser resultados aceptables, la detección de fotogramas por segundo (frames per second, FPS) fue baja y llegó a un promedio de 5. Esta baja detección de FPS impidió que el modelo se utilice para la detección de lesiones en tiempo real. Su validación interna obtuvo una sensibilidad, una especificidad, un VPP y un VPN de 98%, 95%, 98%, y 94%, respectivamente. Posteriormente, al aumentar el número de casos e imágenes disponibles para el entrenamiento (de 81080 a 198941), junto con una mejor calidad de imagen, las métricas de validación interna aumentaron drásticamente: mAP de 0,298 a 0,880, puntaje F1 de 0,280 a 0,738, IoU de 32,3% a 83,2%, pérdida total de 0,1034 a 0,0975. La sensibilidad, la especificidad, el VPP y el VPN para detectar lesiones neoplásicas en imágenes tuvieron resultados similares a los obtenidos por Mascarenhas et al.: 98,6%, 98%, 89,2%, y 99,2%, respectivamente.52,53,55 Sin embargo, al realizar la segunda fase para la validación clínica en 170 pacientes, se observó que estos valores de precisión diagnóstica disminuyeron y se aproximaron a los de los endoscopistas. Durante la comparación del modelo con la impresión visual de los endoscopistas (expertos y no expertos) que usaron dos clasificaciones de lesiones neoplásicas (clasificación CRM y de Mendoza),48,50 se evidenció que el modelo de IA fue superior tanto al de los expertos como al de los no expertos.55 Este estudio demuestra la importancia de realizar una validación clínica y de no extrapolar los resultados de una validación interna a la clínica como resultado final.

Figura 5. Detección de imágenes sugestivas de neoplasia en colangioscopia por medio de la inteligencia artificial (AIWorks- Cholangioscopy, Mdconsgroup, Guayaquil, Ecuador)

Ultrasonido endoscópico

Para el manejo diagnóstico y terapéutico de patologías biliopancreáticas, el EUS se considera superior a la tomografía y a la resonancia magnética debido a su mayor precisión diagnóstica y a su capacidad de obtener imágenes de mejor calidad.56 Sin embargo, estos procedimientos tienen limitaciones como la baja sensibilidad para diferenciar la neoplasia papilar mucinosa intraductal (NPMI) benigna de la maligna, y la baja especificidad para diferenciar las lesiones malignas de la pancreatitis crónica.57 Otra limitación de este procedimiento es su dependencia de los operadores, por lo que los endoscopistas menos experimentados pueden no apreciar las diferencias entre pancreatitis crónica y malignidad pancreática.57 Por esta razón, la aplicación de IA en este tipo de procedimientos sería beneficiosa y podría influenciar la calidad del EUS realizado por endoscopistas expertos o en entrenamiento.58

Se han desarrollado varios estudios para evaluar y comparar la precisión diagnóstica del EUS asistido por IA contra el EUS tradicional en la detección del cáncer pancreático, y distinguir entre lesiones crónicas y tejido normal.55 Un estudio realizado por Norton et al., demostró que su modelo de IA tuvo mayor sensibilidad (100%) para la diferenciación entre malignidad e inflamación, sin embargo, la precisión diagnóstica fue similar entre el modelo (80%), el endoscopista ciego a los resultados del procedimiento (83%) y el procedimiento tradicional (85%).59 Los autores demostraron la posibilidad de aplicar modelos de IA para la interpretación de imágenes en el EUS y la capacidad de distinción entre malignidad y condiciones crónicas; de esta forma resolvieron una de las limitaciones mencionadas anteriormente.

Con el paso del tiempo, se desarrollaron nuevas técnicas de EUS que se incluyeron como parte del manejo de los pacientes. En paralelo, se diseñaron diferentes tipos de IA para diferenciar las lesiones pancreáticas benignas de las malignas. Sãftoiu et al. evaluaron la aplicación de un modelo de IA que permite diferenciar las lesiones benignas de las malignas usando la elastografía, una técnica que evalúa la rigidez y la elasticidad de los tejidos. Obtuvieron altas sensibilidad (91,4%), especificidad (87,9%) y precisión diagnóstica (89,7%).60 Estos resultados indican la posibilidad de aplicar modelos de IA en la elastografía en casos en los que la aspiración con aguja fina guiada por EUS tenga resultados negativos.

Posteriormente, los mismos autores compararon el uso de la elastografía con IA y la elastografía sin IA; observaron que la precisión diagnóstica del primer procedimiento (EUS + IA) fue mayor (AUC: 94%) que la elastografía tradicional (AUC: 85%). Esto sugiere que los modelos de elastografía basados en CNN pueden proporcionar soporte para la toma de decisiones al proveer una interpretación de imágenes rápida y precisa, cuando se los compara con la elastografía sin IA.61

Otra de las limitaciones del EUS que ha sido evaluada es la diferenciación de las NPMI benignas de las malignas. Las NPMI son las precursoras de los adenocarcinomas pancreáticos, y una vez que las lesiones progresan a lesiones invasivas, el pronóstico de los pacientes disminuye.62

Kuwahara et al. desarrollaron un modelo de DL e investigaron si el análisis preoperatorio de imágenes de NPMI por EUS que utiliza IA puede predecir malignidad. Los autores compararon la interpretación de las lesiones con los diagnósticos preoperatorios de los endoscopistas, las técnicas predictivas convencionales y otras técnicas de EUS.63 Como resultado, observaron que el modelo de IA obtuvo una AUC de 91% para predecir malignidad. En la comparación de la precisión diagnóstica entre el modelo y el endoscopista, se observó que el modelo fue superior (94% versus 56%, respectivamente).63

Otra aplicación de la IA en el EUS es el diagnóstico diferencial de lesiones subepiteliales. Hirai et al. evaluaron un modelo de DL que permitía su clasificación en imágenes de EUS. Recolectaron imágenes de lesiones subepiteliales de la vía digestiva alta, incluyendo tumores del estroma gastrointestinal (GIST), leiomiomas, schwannomas, tumores neuroendocrinos y páncreas ectópico. El modelo pudo clasificar las lesiones anteriormente mencionadas con una precisión del 86,1%, la cual fue mucho mayor que la de los endoscopistas participantes.64 La sensibilidad, la especificidad y la precisión diagnóstica para diferenciar los GIST de las demás lesiones fue del 98,8%, 67,6%, y 89,3%, respectivamente.64 Otros estudios, incluyendo metaanálisis que compararon la precisión de otro modelo de CNN para diferenciar los GIST de otras lesiones, tuvieron resultados similares.65

Debido a la tendencia de aumento de neoplasias biliopancreáticas a nivel mundial, es importante poder realizar una adecuada diferenciación entre las lesiones tumorales malignas y las benignas o tejidos normales. La aplicación de la IA en la endoscopia biliopancreática ha sido evaluada por mucho tiempo y mostró resultados prometedores. La IA y su aplicación en medicina se deben considerar beneficiosas porque ayudarán a sobrepasar las limitaciones de estos procedimientos complejos (colangioscopia y EUS).

Aplicaciones futuras de la IA en la endoscopia digestiva

La IA ha demostrado ser útil para detectar y clasificar lesiones durante los distintos tipos de procedimientos endoscópicos disponibles y estudiados. Sin embargo, la aplicación de modelos inteligentes puede ir más allá de la detección y el diagnóstico.

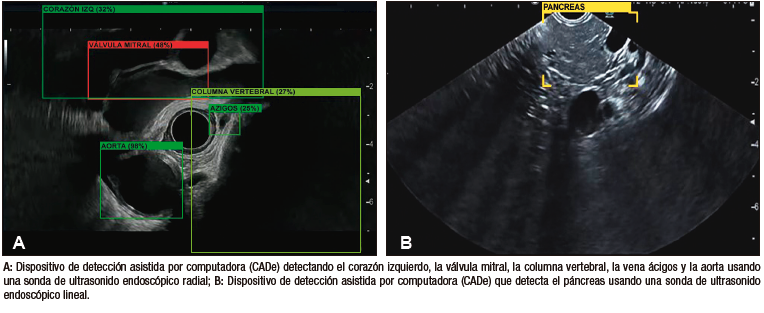

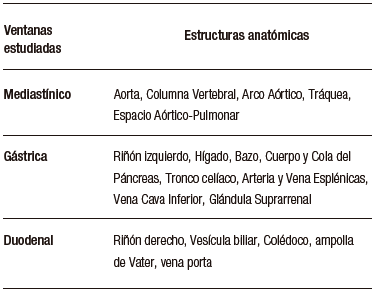

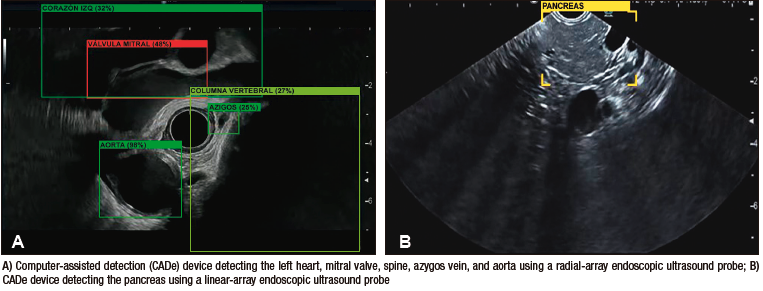

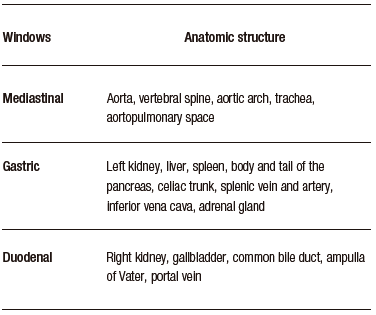

Carlos Robles-Medranda et al., desarrollaron un sistema de EUS basado en modelos de CNN entrenados para detectar estructuras anatómicas normales en las distintas ventanas evaluadas durante este procedimiento avanzado (mediastinal, gástrica y duodenal) (Figura 6), lo que permitió la identificación de 20 estructuras anatómicas con alta sensibilidad y especificidad (Tabla 3).66

La precisión diagnóstica del modelo para detectar dichas estructuras fue mayor al 95%. Esto indica que los modelos de IA no solo tienen utilidad para detectar patologías, sino también para detectar estructuras normales, lo cual puede beneficiar el entrenamiento de los endoscopistas y reforzar el conocimiento de aquellos con más experiencia. La aplicación de la IA en el entrenamiento de los endoscopistas fue evaluada por Zhang et al., quienes demostraron que aquellos endoscopistas entrenados con IA tuvieron una menor curva de aprendizaje y mejores resultados que aquellos entrenados tradicionalmente.67

Figura 6. Modelo de inteligencia artificial de ultrasonido endoscópico detectando estructuras anatómicas (AIWorks-EUS, mdconsgroup, Guayaquil, Ecuador)

Tabla 3. Estructuras anatómicas observadas por el sistema de detección asistido por computadora AIWorks-EUS (Mdconsgroup, Guayaquil, Ecuador)

Adicionalmente, por medio de modelos inteligentes, es posible automatizar el proceso de obtención de imágenes para la generación de reportes y como medidor de calidad de las pruebas.68 Esto se puede llevar a cabo por medio de la unión de varias funciones y su aplicación simultánea, como la detección del órgano valorado junto con la detección de lesiones dentro de ese órgano. De esta manera, al final del procedimiento, se puede generar de manera automática el reporte del estudio realizado.68,69 Modelos como el AI-EARS y el ISRGS han demostrado buena precisión diagnóstica para identificar los órganos y las lesiones, generando un reporte automático utilizando IA tanto en vía digestiva alta68 como en baja.69

La aplicación de modelos de IA para entrenar a endoscopistas en procedimientos endoscópicos avanzados puede aumentar la eficacia de dichos endoscopistas y disminuir el número de procedimientos necesarios para alcanzar competencia.

Conclusión

A pesar de que la automatización de los modelos durante la endoscopia busca reducir los riesgos derivados de factores humanos y ambientales, entre otros, el éxito los modelos de IA dependerá de la calidad y la cantidad de información utilizada durante su entrenamiento y validación. Asimismo, cobra gran importancia la validación externa por medio de estudios multicéntricos e internacionales con endoscopistas expertos antes de la generalización y la universalización de los resultados del entrenamiento.

Los modelos de IA en la endoscopia digestiva tienen el potencial de mejorar la precepción visual de los endoscopistas, y acercar la precisión entre aquellos con menos experiencia y los considerados expertos. Además, pueden ser de gran ayuda en la detección de lesiones y en la evaluación de la invasión en los tejidos. Se vislumbra un futuro en el cual los enfoques de formación tradicionales serán superados y los centros médicos en todo el mundo podrán implementar mejoras en la capacitación de los profesionales, mediante la aplicación de tecnologías precisas que reduzcan la curva de aprendizaje en estos procedimientos. Esto beneficiará a los profesionales menos experimentados y reducirá la brecha entre los endoscopistas expertos y los de menor experiencia, mejorando la competencia de los endoscopistas.

Propiedad intelectual. Los autores declaran que los datos, las figuras y las tablas presentes en el manuscrito son originales y se realizaron en sus instituciones pertenecientes.

Financiamiento. Los autores declaran que no hubo fuentes de financiación externas.

Conflicto de interés. Carlos Robles-Medranda es un líder de opinión y consultor para Pentax Medical, Steris, Micro-tech, G-Tech Medical Supply, CREO Medical, EndoSound y Mdconsgroup. Los demás autores no declaran ningún conflicto de interés.

Aviso de derechos de autor

© 2023 Acta Gastroenterológica Latinoamericana. Este es un artículo de acceso abierto publicado bajo los términos de la Licencia Creative Commons Attribution (CC BY-NC-SA 4.0), la cual permite el uso, la distribución y la reproducción de forma no comercial, siempre que se cite al autor y la fuente original.

Cite este artículo como: Baquerizo-Burgos J, Egas-Izquierdo M, Cunto D y col. La era de la endoscopia inteligente: cómo la inteligencia artificial potencia la endoscopia digestiva. Acta Gastroenterol Latinoam. 2023;53(3):211-225. https://doi.org/10.52787/agl.v53i3.339

Referencias

- Ramesh AN, Kambhampati C, Monson JRT, Drew PJ. Artificial Intelligence in Medicine. Ann R Coll Surg Engl. 2004;86(5):334-8.

- Tonozuka R, Mukai S, Itoi T. The Role of Artificial Intelligence in Endoscopic Ultrasound for Pancreatic Disorders. Diagnostics. 2021;11(1).

- Minoda Y, Ihara E, Fujimori N, Nagatomo S, Esaki M, Hata Y, et al. Efficacy of Ultrasound Endoscopy with Artificial Intelligence for the Differential Diagnosis of Non-Gastric Gastrointestinal Stromal Tumors. Sci Rep. 2022;12(1).

- Kröner PT, Engels MM, Glicksberg BS, Johnson KW, Mzaik O, van Hooft JE, et al. Artificial Intelligence in Gastroenterology: A State-Of-The-Art Review. World J Gastroenterol. 2021;27(40):6794-6824.

- Yu KH, Beam AL, Kohane IS. Artificial Intelligence in Healthcare. Nat Biomed Eng. 2018;2(10):719-31.

- Firmino M, Angelo G, Morais H, Dantas MR, Valentim R. Computer-Aided Detection (CADe) and Diagnosis (CADx) System for Lung Cancer with Likelihood of Malignancy. Biomed Eng Online. 2016;15(1):2.

- Takiyama H, Ozawa T, Ishihara S, Fujishiro M, Shichijo S, Nomura S, et al. Automatic anatomical classification of esophagogastroduodenoscopy images using deep convolutional neural networks. Sci Rep. 2018;8:7497.

- Van der Sommen F, Zinger S, Curvers WL, Bisschops R, Pech O, Weusten BL, et al. Computer-Aided Detection of Early Neoplastic Lesions in Barrett’s Esophagus. Endoscopy. 2016;48:617-624.

- Kumagai Y, Takubo K, Kawada K, Aoyama K, Endo Y, Ozawa T, et al. Diagnosis Using Deep-Learning Artificial Intelligence Based on the Endocytoscopic Observation of the Esophagus. Esophagus. 2019;16:180-187.

- Horie Y, Yoshio T, Aoyama K, Yoshimizu S, Horiuchi Y, Ishiyama A, et al. Diagnostic Outcomes of Esophageal Cancer by Artificial Intelligence Using Convolutional Neural Networks. Gastrointest Endosc. 2019;89:25-32.

- Luo H, Xu G, Li C, He L, Luo L, Wang Z, et al. Real-Time Artificial Intelligence for Detection of Upper Gastrointestinal Cancer by Endoscopy: A Multicentre, Case-Control, Diagnostic Study. Lancet Oncol. 2019;20(12):1645-1654.

- Cao JS, Lu ZY, Chen MY, Zhang B, Juengpanich S, Hu JH, et al. Artificial Intelligence in Gastroenterology and Hepatology: Status and Challenges. World J Gastroenterol. 2021;27(16):1664-1690.

- Hashimoto R, Requa J, Dao T, Ninh A, Tran E, Mai D, et al. Artificial Intelligence Using Convolutional Neural Networks for Real-Time Detection of Early Esophageal Neoplasia in Barrett’s Esophagus (With Video). Gastrointest Endosc 2020;91: 1264-1271.e1

- Ebigbo A, Mendel R, Probst A, Manzeneder J, Prinz F, de Souza LA Jr, et al. Real-Time Use of Artificial Intelligence in The Evaluation of Cancer in Barrett’s Oesophagus. Gut. 2020;69:615-616.

- De Groof AJ, Struyvenberg MR, van der Putten J, van der Sommen F, Fockens KN, Curvers WL, et al. Deep-Learning System Detects Neoplasia in Patients With Barrett’s Esophagus With Higher Accuracy Than Endoscopists in a Multistep Training and Validation Study With Benchmarking. Gastroenterology. 2020;158(4):915-929.e4.

- Cai SL, Li B, Tan WM, Niu XJ, Yu HH, Yao LQ, et al. Using a Deep Learning System in Endoscopy for Screening of Early Esophageal Squamous Cell Carcinoma (With Video). Gastrointest Endosc 2019;90: 745-753:e2

- Tokai Y, Yoshio T, Aoyama K, Horie Y, Yoshimizu S, Horiuchi Y, et al. Application of Artificial Intelligence Using Convolutional Neural Networks in Determining the Invasion Depth of Esophageal Squamous Cell Carcinoma. Esophagus. 2020;17:250-256.

- Menon S, Trudgill N. How Commonly is Upper Gastrointestinal Cancer Missed at Endoscopy? Endosc Int Open. 2014;2:E46-E50

- Wu L, Zhang J, Zhou W, An P, Shen L, Liu J, et al. Randomised Controlled Trial of WISENSE, a Real-Time Quality Improving System for Monitoring Blind Spots During Esophagogastroduodenoscopy. Gut. 2019;68:2161-2169.

- Ali H, Yasmin M, Sharif M, Rehmani MH. Computer Assisted Gastric Abnormalities Detection Using Hybrid Texture Descriptors for Chromoendoscopy Images. Comput Methods Programs Biomed. 2018;157:39-47.

- Nagao S, Tsuji Y, Sakaguchi Y, Takahashi Y, Minatsuki C, Niimi K, et al. Highly Accurate Artificial Intelligence Systems to Predict the Invasion Depth of Gastric Cancer: Efficacy of Conventional White-Light Imaging, Nonmagnifying Narrow-Band Imaging, and Indigo-Carmine Dye Contrast Imaging. Gastrointest Endosc 2020;92:866-873:e1.

- Sakai Y, Takemoto S, Hori K, Nishimura M, Ikematsu H, Yano T, et al. Automatic Detection of Early Gastric Cancer in Endoscopic Images Using a Transferring Convolutional Neural Network. Conf Proc IEEE Eng Med Biol Soc. 2018;2018:4138-4141.

- Tsujii Y, Kato M, Inoue T, Yoshii S, Nagai K, Fujinaga T, et al. Integrated Diagnostic Strategy for the Invasion Depth of Early Gastric Cancer by Conventional Endoscopy and EUS. Gastrointest Endosc. 2015;82(3):452-9

- Wang CC, Chiu YC, Chen WL, Yang TW, Tsai MC, Tseng MH. A Deep Learning Model for Classification of Endoscopic Gastroesophageal Reflux Disease. Int J Environ Res Public Health. 2021;18(5):2428.

- Shichijo S, Endo Y, Aoyama K, Takeuchi Y, Ozawa T, Takiyama H, et al. Application of Convolutional Neural Networks for Evaluating Helicobacter Pylori Infection Status on the Basis of Endoscopic Images. Scand J Gastroenterol. 2019;54(2):158-163.

- Le Berre C, Sandborn WJ, Aridhi S, Devignes MD, Fournier L, Smaïl-Tabbone M, et al. Application of Artificial Intelligence to Gastroenterology and Hepatology. Gastroenterology. 2020;158(1):76-94.e2.

- Seguí S, Drozdzal M, Pascual G, Radeva P, Malagelada C, Azpiroz F, et al. Generic Feature Learning for Wireless Capsule Endoscopy Analysis. Comput Biol Med. 2016;79:163-172.

- Pannala R, Krishnan K, Melson J, Parsi MA, Schulman AR, Sullivan S, et al. Artificial Intelligence in Gastrointestinal Endoscopy. VideoGIE. 2020;5(12):598-613.

- Chen H, Wu X, Tao G, Peng Q. Automatic Content Understanding with Cascaded Spatial-Temporal Deep Framework for Capsule Endoscopy Videos. Neurocomputing. 2017;229:77-87.

- Ding Z, Shi H, Zhang H, Meng L, Fan M, Han C, et al. Gastroenterologist-Level Identification of Small-Bowel Diseases and Normal Variants by Capsule Endoscopy Using a Deep-Learning Model. Gastroenterology. 2019;157(4):1044-1054.e5.

- Aoki T, Yamada A, Kato Y, Saito H, Tsuboi A, Nakada A, et al. Automatic Detection of Blood Content in Capsule Endoscopy Images Based on a Deep Convolutional Neural Network. J Gastroenterol Hepatol. 2020;35(7):1196-1200.

- Xiao Jia, Meng MQ. A Deep Convolutional Neural Network for Bleeding Detection in Wireless Capsule Endoscopy Images. Annu Int Conf IEEE Eng Med Biol Soc. 2016;2016:639-642

- Usman MA, Satrya GB, Usman MR, Shin SY. Detection of Small Colon Bleeding in Wireless Capsule Endoscopy Videos. Comput Med Imaging Graph. 2016;54:16-26.

- Leenhardt R, Vasseur P, Li C, Saurin JC, Rahmi G, Cholet F, et al. A Neural Network Algorithm for Detection of GI Angiectasia During Small-Bowel Capsule Endoscopy. Gastrointest Endosc. 2019;89:189-194.

- Sengupta N, Tapper EB. Derivation and Internal Validation of a Clinical Prediction Tool for 30-Day Mortality in Lower Gastrointestinal Bleeding. Am J Med 2017;130: 601.e1-601:e8.

- Soffer S, Klang E, Shimon O, Nachmias N, Eliakim R, Ben-Horin S, et al. Deep Learning For Wireless Capsule Endoscopy: A Systematic Review and Meta-Analysis. Gastrointest Endosc. 2020;92:831–839.e8.

- Qin K, Li J, Fang Y, Xu Y, Wu J, Zhang H, et al. Convolution Neural Network for the Diagnosis of Wireless Capsule Endoscopy: A Systematic Review and Meta-Analysis. Surg Endosc. 2022;36(1):16-31.

- Pannala R, Krishnan K, Melson J, Parsi MA, Schulman AR, Sullivan S, et al. Artificial Intelligence in Gastrointestinal Endoscopy. VideoGIE. 2020;5(12):598-613.

- Khorasani HM, Usefi H, Peña-Castillo L. Detecting Ulcerative Colitis From Colon Samples Using Efficient Feature Selection and Machine Learning. Sci Rep. 2020;10:13744.

- Wang P, Berzin TM, Glissen Brown JR, Bharadwaj S, Becq A, Xiao X, et al. Real-Time Automatic Detection System Increases Colonoscopic Polyp and Adenoma Detection Rates: A Prospective Randomized Controlled Study. Gut. 2019;68(10):1813-1819.

- Zhao S, Wang S, Pan P, Xia T, Chang X, Yang X, et al. Magnitude, Risk Factors, and Factors Associated with Adenoma Miss Rate of Tandem Colonoscopy: A Systematic Review and Meta-analysis. Gastroenterology. 2019;156 (6):1661-1674e11.

- Gohari MR, Biglarian A, Bakhshi E, Pourhoseingholi MA. Use of an Artificial Neural Network to Determine Prognostic Factors in Colorectal Cancer Patients. Asian Pac J Cancer Prev. 2011;12:1469-1472.

- Biglarian A, Bakhshi E, Gohari MR, Khodabakhshi R. Artificial Neural Network for Prediction of Distant Metastasis in Colorectal Cancer. Asian Pac J Cancer Prev. 2012;13:927-930.

- Hassan C, Spadaccini M, Iannone A, Maselli R, Jovani M, Chandrasekar VT. Performance of Artificial Intelligence in Colonoscopy for Adenoma and Polyp Detection: A Systematic Review and Meta-Analysis. Gastrointest Endosc. 2021;93(1):77-85.e6

- Robles-Medranda C, Cifuentes-Gordillo C, Arevalo-Mora M, Egas-Izquierdo M, Puga-Tejada M, Cunto D, et al. Real-Time Computer-Aided Polyp and Adenoma Detection During Screening Colonoscopy in Expert And Non-Expert Endoscopists: A Single Center Study. Endoscopy. 2023;55(S 02):S232-S233.

- Khorasani HM, Usefi H, Peña-Castillo L. Detecting Ulcerative Colitis from Colon Samples Using Efficient Feature Selection and Machine Learning. Sci Rep. 2020;10:13744.

- Kahaleh M, Gaidhane M, Raijman I, Tyberg A, Sethi A, Slivka A, et al. Digital Cholangioscopic Interpretation: When North Meets the South. Dig Dis Sci. 2022;67(4):1345-1351.

- Robles-Medranda C, Valero M, Soria-Alcivar M, Puga-Tejada M, Oleas R, Ospina-Arboleda J, et al. Reliability and Accuracy of a Novel Classification System Using Peroral Cholangioscopy for the Diagnosis of Bile Duct Lesions. Endoscopy. 2018;50(11):1059-70.

- Robles-Medranda C, Oleas R, Sánchez-Carriel M, Olmos JI, Alcívar-Vásquez J, Puga-Tejada M, et al. Vascularity Can Distinguish Neoplastic From Non-Neoplastic Bile Duct Lesions During Digital Single-Operator Cholangioscopy. Gastrointest Endosc. 2021;93(4):935-41.

- Kahaleh M, Gaidhane M, Shahid HM, Tyberg A, Sarkar A, Ardengh JC, et al. Digital Single-Operator Cholangioscopy Interobserver Study Using A New Classification: The Mendoza Classification (With Video). Gastrointest Endosc. 2022;95(2):319-26.

- Sethi A, Tyberg A, Slivka A, Adler DG, Desai AP, Sejpal D V., et al. Digital Single-operator Cholangioscopy (DSOC) Improves Interobserver Agreement (IOA) and Accuracy for Evaluation of Indeterminate Biliary Strictures: The Monaco Classification. J Clin Gastroenterol. 2022;56(2).

- Saraiva MM, Ribeiro T, Ferreira JPS, Boas FV, Afonso J, Santos AL, et al. Artificial Intelligence for Automatic Diagnosis of Biliary Stricture Malignancy Status in Single-Operator Cholangioscopy: A Pilot Study. Gastrointest Endosc. 2022;95(2):339-48.

- Pereira P, Mascarenhas M, Ribeiro T, Afonso J, Ferreira JPS, Vilas-Boas F, et al. Automatic Detection of Tumor Vessels in Indeterminate Biliary Strictures in Digital Single-Operator Cholangioscopy. Endosc Int Open. 2022;10(03):E262-8.

- Marya NB, Powers PD, Petersen BT, Law R, Storm A, Abusaleh RR, et al. Identification of Patients with Malignant Biliary Strictures Using a Cholangioscopy-Based Deep Learning Artificial Intelligence (With Video). Gastrointest Endosc. 2022.

- Robles-Medranda C, Baquerizo-Burgos J, Alcívar-Vásquez J, Kahaleh M, Raijman I, Kunda R, et al. Artificial Intelligence for Diagnosing Neoplasia on Digital Cholangioscopy: Development and Multicentric Validation of a Convolutional Neural Network Model. Endoscopy. 2023.

- Dahiya DS, Al-Haddad M, Chandan S, Gangwani MK, Aziz M, Mohan BP, et al. Artificial Intelligence in Endoscopic Ultrasound for Pancreatic Cancer: Where Are We Now and What Does the Future Entail? J Clin Med. 2022;11(24):7476.

- Shahidi N, Ou G, Lam E, Enns R, Telford J. When Trainees Reach Competency in Performing Endoscopic Ultrasound: A Systematic Review. Endosc Int Open. 2017;05(04):E239-43.

- Goyal H, Mann R, Gandhi Z, Perisetti A, Zhang Z, Sharma N, et al. Application of Artificial Intelligence in Pancreaticobiliary Diseases. Ther Adv Gastrointest Endosc. 2021; 14:1-12.

- Norton ID, Zheng Y, Wiersema MS, Greenleaf J, Clain JE, DiMagno EP. Neural Network Analysis of EUS Images to Differentiate Between Pancreatic Malignancy and Pancreatitis. Gastrointest Endosc. 2001;54(5):625-9.

- Sãftoiu A, Vilman P. Endoscopic ultrasound elastography Endoscopic Ultrasound Elastography-a New Imaging Technique for the Visualization of Tissue Elasticity Distribution. J Gastrointestin Liver Dis. 2006;15(2):161-5.

- Sǎftoiu A, Vilmann P, Gorunescu F, Janssen J, Hocke M, Larsen M, et al. Efficacy of an Artificial Neural Network-Based Approach to Endoscopic Ultrasound Elastography in Diagnosis of Focal Pancreatic Masses. Clin Gastroenterol Hepatol. 2012;10(1).

- Brosens LAA, Hackeng WM, Offerhaus J, Hruban RH, Wood LD. Pancreatic Adenocarcinoma Pathology: Changing “Landscape.” J Gastrointest Oncol. 2015;6(4):358–74.

- Kuwahara T, Hara K, Mizuno N, Okuno N, Matsumoto S, Obata M, et al. Usefulness of Deep Learning Analysis for the Diagnosis of Malignancy in Intraductal Papillary Mucinous Neoplasms of the Pancreas. Clin Transl Gastroenterol. 2019;10(5).

- Hirai K, Kuwahara T, Furukawa K, Kakushima N, Furune S, Yamamoto H, et al. Artificial Intelligence-Based Diagnosis of Upper Gastrointestinal Subepithelial Lesions on Endoscopic Ultrasonography Images. Gastric Cancer. 2022;25(2):382-91.

- Minoda Y, Ihara E, Fujimori N, Nagatomo S, Esaki M, Hata Y, et al. Efficacy of Ultrasound Endoscopy with Artificial Intelligence for the Differential Diagnosis of Non-Gastric Gastrointestinal Stromal Tumors. Sci Rep. 2022;12(1).

- Robles-Medranda C, Oleas R, Del Valle R, Mendez JC, Alcívar-Vásquez J, Puga-Tejada M, et al. ID: 3521955 Application of Artificial Intelligence For Real-Time Anatomical Recognition During Endoscopic Ultrasound Evaluation: A Pilot Study. Gastrointest Endosc. 2021;93(6):AB221.

- Zhang J, Zhu L, Yao L, Ding X, Chen D, Wu H. Deep Learning-Based Pancreas Segmentation and Station Recognition System in EUS: Development and Validation of Auseful Training Tool (With Video). Gastrointest Endosc. 2020;92(4):874-885.e3

- Zhang L, Lu Z, Yao L, Dong Z, Zhou W, He C, et al. Effect of a Deep Learning-based Automatic Upper GI Endoscopic Reporting System: A Randomized Crossover Study (With Video). Gastrointest Endosc. 2023; 98(2): 181 – 190

- Qu JY, Li Z, Su JR, Ma MJ, Xu CQ, Zhang AJ, et al. Development and Validation of an Automatic Image-Recognition Endoscopic Report Generation System: A Multicenter Study. Clin Transl Gastroenterol. 202; 12(1): e00282.

Correspondencia: Jorge Baquerizo-Burgos

Correo electrónico: jorgebaquerizoburgos@gmail.com

Acta Gastroenterol Latinoam 2023;53(3):211-225

The Era of Intelligent Endoscopy: How Artificial Intelligence Empowers Digestive Endoscopy

Jorge Baquerizo-Burgos ID· Maria Egas-Izquierdo ID· Doménica Cunto ID· Carlos Robles-Medranda ID

Endsocopy Division, Instituto Ecuatoriano de Enfermedades Digestivas (IECED), Guayaquil, Ecuador.

Acta Gastroenterol Latinoam 2023;53(3):226-240

Received: 09/08/2023 / Accepted: 14/09/2023 / Published online 29/09/2023 /

https://doi.org/10.52787/agl.v53i3.339

Summary

Artificial intelligence is a field of science and engineering that focuses on the computational understanding of intelligent behaviors and the creation of artifacts that exhibit such behaviors, enabling computers to function and think like humans. This technology assists in overcoming the multiple challenges faced by healthcare professionals and contributes to the diagnosis, management, and prognosis of patients. Currently, several artificial intelligence models have been developed for digestive endoscopy, including models that allow the detection of anatomical structures that can assist in the training of physicians, serve as a guide during endoscopic procedures, or assist in stratifying premalignant and malignant lesions. This would reduce false negatives and provide more timely treatments. Computerized systems for lesion detection and diagnosis exist for different segments of the digestive tract, each with specific functions that provide assistance during procedures. All of this has been aimed at reducing risks stemming from human and environmental factors, among others, which can affect the diagnosis and management of diseases. Artificial intelligence models for digestive endoscopy can not only enhance the visual impression of endoscopists but also reduce the learning curve through the application of precise technologies. In this way, the gap between experienced and less experienced endoscopists is reduced. In this article, the technological advancements of artificial intelligence in digestive endoscopy and related future aspects are discussed.

Keywords. Artificial intelligence, computer-assisted detection, computer-assisted diagnosis, deep learning, endoscopy.

La era de la endoscopia inteligente: cómo la inteligencia artificial potencia la endoscopia digestivas

Resumen

La inteligencia artificial es un campo de la ciencia e ingeniería que se ocupa de la comprensión computacional de comportamientos inteligentes y la creación de artefactos que exhiben tales comportamientos, lo que permite a las computadoras funcionar y pensar de manera similar a la de los seres humanos. Esta tecnología ayuda a superar los múltiples retos que enfrentan los profesionales de la salud aportando favorablemente en el diagnóstico, manejo y pronóstico de los pacientes. Actualmente se han desarrollado varios modelos a nivel de endoscopia digestiva, incluyendo algunos que permiten la detección de estructuras anatómicas que pueden ayudar en el entrenamiento de médicos, como guía durante procedimientos endoscópicos o para la estratificación de lesiones pre-malignas y malignas, disminuyendo falsos negativos y proporcionar tratamientos oportunos. En la actualidad existen sistemas computarizados de detección de lesiones y de diagnóstico en los distintos segmentos de la vía digestiva, cada uno con funciones particulares que proporcionan asistencia durante los procedimientos. Todo esto se ha llevado a cabo con el fin de reducir riesgos derivados por factores humanos, ambientales, entre otros, los cuales pueden afectar el diagnóstico y manejo de enfermedades. Los modelos de inteligencia artificial para endoscopía digestiva pueden, además de mejorar la impresión visual de los endoscopistas, disminuir la curva de aprendizaje a través de la aplicación de tecnologías precisas, y de esta manera reducir la diferencia entre endoscopistas expertos y menos expertos. En este artículo se discuten los avances tecnológicos de la inteligencia artificial en endoscopia digestiva y los aspectos futuros relacionados.

Palabras claves. Inteligencia artificial, detección asistida por computadora, diagnóstico asistido por computadora, aprendizaje profundo, endoscopia.

Abbreviations

AI: Artificial Intelligence.

ML: Machine learning.

DL: Deep learning.

CADe: Computer-assisted detection device.

CADx: Computer-assisted diagnostic device.

EUS: Endoscopic ultrasound.

EGD: Esophagogastroduodenoscopy.

AUC: Area under the curve.

BE: Barrett’s Esophagus.

SCEC: Squamous cell esophageal carcinoma.

NBI: Narrow Band Imaging.

GERD: Gastroesophageal reflux disease.

SVM: Support Vector Machine.

CNN: Convolutional Neural Network.

CRC: Colorectal cancer.

ADR: Adenoma Detection Rate.

RR: Relative risk.

APC: Adenoma per Colonoscopy.

PDR: Polyp Detection Rate.

ERCP: Endoscopic retrograde cholangiopancreatography.

PPV: Positive Predictive Value.

NPV: Negative Predictive Value.

mAP: Mean Average Precision.

FPS: Frames per Second.

IoU: Intersection over the union.

CT: Computerized tomography.

MRI: Magnetic resonance imaging.

IPMN: Intraductal papillary mucinous neoplasm.

SEL: Subepithelial Lesion.

GIST: Gastrointestinal Stromal Tumor.

NET: Neuroendocrine Tumor.

Introduction

Artificial Intelligence: Basic Concepts

Artificial intelligence (AI) is a branch of computer science whose purpose is the understanding and execution of intelligent insights from a set of computational models.1 Using a set of algorithms, AI is capable of functioning and reasoning like a human being through a learning process based on training and has the advantage of being able to complete it in less time than a human being.1 Additionally, this technology can incorporate machine learning (ML) and its subset, deep learning (DL).2

ML is a subgroup of AI characterized by the use of mathematical models for learning from data, which later enables pattern recognition.3 Predictive models are created from algorithms, allowing for data analysis and the resolution of complex problems. Additionally, ML can be categorized into three types: supervised, unsupervised, and reinforcement2,4,5:

a) Supervised learning: this type of learning is based on training using well-categorized or labeled data (external supervision). Labeled data is divided for both training and internal validation. Supervised learning is based on regression, classification, and characterization.2,3

b) Unsupervised learning: this model learns from uncategorized data, enabling the algorithm to operate without any guidance, relying on the understanding of patterns and thus requiring a greater amount of information.2,3

c) Reinforcement learning: it does not require data or supervision to learn; instead, it is based on learning from the environment through rewards.2,3

DL is a specialized category of ML that is based on the architecture of neural networks resembling those in the human brain.3 It consists of an initial layer that receives input; this layer if followed by a set of hidden middle layers, and then the final output layer (Figure 1). Each layer in this network comprises a group of neurons or nodes that transform (activate) an input into an output through mathematical functions.2 The output of a previous layer serves as the input for the next layer, and so on, until reaching the output layer to obtain a final outcome or detection.2,3

Figure 1. Schematic representation of the architecture of convolutional neural network models

The development of a detection model based on DL involves three main phases. In the first phase, data (images or videos) is collected, and the structures to be used in training the model are properly labeled. Next, in the second phase, the model’s architecture is established, and neural networks are created (input layer, middle layer, and output layer). Finally, in the third phase, the samples obtained in the previous phases are used to train the model and subsequently validate it internally (Figure 2).1 The metrics for evaluating the model’s performance are obtained from this final phase (Table 1).

Figure 2. Phases of deep learning model development

Table 1. Metrics obtained for the performance evaluation of deep learning models

Clinical Applications of Artificial Intelligence

Clinical applications of AI have progressively increased in the field of healthcare, including gastroenterology. AI helps overcome the numerous challenges faced by healthcare professionals during data acquisition, analysis, and knowledge application that contributes to patient diagnosis, management, and prognosis.1 Additionally, automation in image identification and recognition assists in reducing errors stemming from human factors (fatigue and workload, among others).

Technological advancements have led to the development of intelligent systems that facilitate the detection or the stratification of lesions observed during endoscopic or imaging procedures. These are referred to as computer-assisted detection device (CADe) or computer-assisted diagnostic device (CADx).6 Thus, the application of these devices in digestive endoscopy can facilitate and increase lesion detection during procedures and categorize lesions as benign or malignant in real-time.

Artificial intelligence in Digestive Endoscopy

Currently, several models have been developed for upper and lower gastrointestinal endoscopy, as well as for advanced endoscopic procedures such as cholangioscopy and endoscopic ultrasound (EUS) (Table 2). These models encompass both CADe and CADx systems, each employing distinct algorithms that enable different functionalities. These functionalities include identifying anatomical structures and specific lesions, assisting in physician training or serving a guide during endoscopic procedures, reducing the number of false negatives through characterization and stratification of premalignant and malignant lesions, among others.4

Table 2. Applications of artificial intelligence in different segments of the digestive system

In the following sections, we will review updated information on the uses of AI and its impact according to the type of endoscopic assessment.

Upper Digestive Endoscopy

Also known as esophagogastroduodenoscopy (EGD), this procedure is of great importance in the diagnosis of upper gastrointestinal tract lesions.7,8 However, the diagnostic rate varies according to the performance of the endoscopist.9 Errors during EGD are one of the leading causes of incorrect diagnosis of premalignant lesions and severe esophagogastricduodenal diseases. AI systems have been developed to overcome the technical challenges described above. Their use in the upper digestive tract ranges from anatomical localization to the detection and evaluation of malignant and premalignant lesions.7-10

Takiyama et al. developed an AI model capable of classifying anatomical structures in the upper digestive tract, which has shown excellent performance in identifying the larynx (AUC 1.00), the esophagus (AUC 1.00), the stomach (upper, middle, and lower portions), and the duodenum (AUC 0.99).7

On the other hand, in the multicenter study conducted by Luo et al., the diagnostic accuracy of the GRADIS model for detecting upper digestive tract neoplasms (esophagus and stomach) was evaluated. This model achieved a diagnostic accuracy of 95.5% (95% CI: 95.2 – 95.7) during internal validation. When comparing its performance with endoscopists of different expertise levels, it showed similar sensitivity to experts (94.2% vs. 94.5%), and higher sensitivity compared to competent endoscopists (94.2% vs. 85.8%) and trainees (94.2% vs. 72.2%).11 Additionally, the diagnostic accuracy of experts (92.8%) when using the AI model was similar to that of the group of competent endoscopists (93.4%) and trainees (90.4%).11 This demonstrates that the application of AI can narrow the gap between experts and non-experts.11

Esophagus

Accuracy in the early diagnosis of Barrett’s esophagus (BE) and esophageal neoplasia remains a challenge, even for many experienced endoscopists. Once BE is identified, the identification of regions with dysplasia or early adenocarcinoma becomes necessary.

AI models have been designed to assist endoscopists in improving the accuracy of diagnosing these lesions,12 including systems for neoplasia classification using real-time magnification with high precision (89.9%), which have enabled early diagnosis and differentiation of neoplasia in BE.13,14

The CADx system developed and validated by de Groof et al. allowed for the classification of neoplastic and non-neoplastic images in BE compared to the performance of 53 endoscopists. The model outperformed the endoscopists’ performance and achieved higher accuracy (88.0% vs. 73.0%), sensitivity (93.0% vs. 72.0%), and specificity (83.0% vs. 74.0%).15

On the other hand, due to the significant importance of recognizing and treating esophageal carcinoma promptly, researchers have developed systems that enable lesion detection as well as the assessment of disease invasion.12,16,17 Esophageal carcinoma is often detected at advanced stages, and small lesions are usually detected by highly experienced endoscopists.12 AI allows for the detection of lesions smaller than 10 mm with high accuracy (91.4%), even surpassing that of many so-called expert endoscopists (> 15 years of experience, 88.8%), those with moderate experience (5 – 15 years, 81.6%), and those with limited experience (< 5 years, 77.2%).16

Determining the depth of the lesion enables the selection of the appropriate treatment (surgical, endoscopic, pharmacological), and prognosis assessment.17 One of the models with high diagnostic accuracy in predicting the depth of invasion of squamous cell esophageal carcinoma (SCEC) is proposed by Tokai et al. Researchers used 1751 images for training and 291 images for validation, achieving a sensitivity of 84.1% and a diagnostic accuracy of 80.9% in estimating the depth of SCEC invasion. When compared to thirteen endoscopists, this model showed higher diagnostic accuracy and a greater AUC.17

Stomach

Stomach cancer usually shows nonspecific symptoms during its early stages, and that´s why patients are often diagnosed at advanced stages. The prognosis of stomach cancer depends on the assessment of the depth of the lesion and its early detection. It has been reported that the early detection of stomach cancer can increase 5-year survival rates to 90.0%.18

According to Menon et al., the rate of false negatives in the diagnosis of early stomach cancer can reach up to 25.0%.18 Automation systems aim to reduce this percentage with models that classify stomach images in EGD to monitor blind spots with high precision,19 models that detect lesions suggestive of stomach cancer11 and precancerous lesions,20 and that further assess the depth of invasion.21

Chromoendoscopy is one of the diagnostic methods used for the early detection of gastric neoplasm. However, during an endoscopic session, multiple video frames can be generated, making the review process an exhaustive task for endoscopists.

To prevent losses during evaluation, Ali et al. developed a CADx trained to classify frames as normal or pathological based on local and global texture. This model showed a sensitivity, specificity, precision, and AUC of 91.0%, 82.0%, 87.0%, and 0.91, respectively.22 The model proved to be a diagnostic aid in the early detection of gastric cancer since it reduces the time used for the evaluation of endoscopic sequence.

The model studied by Wu et al. 19 showed high accuracy, specificity, and sensitivity (92.5%, 94.0%, 91.0%, respectively) in assessing non-malignancy, and surpassing expert endoscopists in this task.19 Additionally, during real-time procedures, it showed excellent performance in early gastric adenocarcinoma detection with blind-spot monitoring. Additionally, other AI models have shown high accuracy in diagnosing gastrointestinal neoplasia comparable to that of expert endoscopists.11,17

Furthermore, models have been developed that not only identify neoplastic lesions but also predict their depth. Nagao et al. trained a model to predict the depth of invasion of gastric cancer using conventional white-light images, narrow band imaging (NBI) images, and images with indigo carmine contrast.21 The model showed high accuracy across all three systems (white-light images 94.5%, NBI 94.3%, and indigo carmine 95.5%).21

Zhu et al. (total accuracy 89.2%) and Yoon et al. (sensitivity 81.7%. specificity 75.4%) have reported diagnostic accuracy of their models for assessing invasion depth, which is comparable to that of other conventional methods. The advantages of using these models lie in the more objective assessment of macroscopic lesion characteristics, reducing the need for other invasive techniques like EUS.21,23,24

In addition to neoplasia identification, other applications include the detection of gastroesophageal reflux disease (GERD)25 and H. pylori-associated gastritis.26 Models developed to assist in classifying GERD with NBI have achieved a total diagnostic accuracy of 99.2% for grade A-B lesions, 100% for grade C-D lesions, and 100% in the control group. Therefore, these models are considered highly useful for assisting in the automatic detection of lesions consistent with GERD, and increase diagnostic accuracy for trainees.25

On the other hand, the neural network designed for predicting H. pylori in endoscopic images correctly diagnosed 80% of negative cases, 84% of eradicated cases, and 48% of positive cases. The authors of this study emphasize the utility of this model in identifying patients who may require additional confirmation testing for H. pylori based on endoscopic results, and recommend its use as a diagnostic aid.26

Small Intestine

Capsule endoscopy, as a non-invasive procedure allows for the detection and classification of lesions (bleeding, ulcers, and polyps), assessment of intestinal motility, and evaluation of conditions like celiac disease and other pathologies that primarily affect the small intestine. However, the evaluation of the large number of obtained images (> 60 000) and the difficulty in directing the capsule (completely dependent on gastrointestinal peristalsis) make the procedure slow (from 45 minutes to 8 hours) and tedious. To address the technical difficulties associated with this procedure, automation using AI has been explored.28

AI models for capsule endoscopy have been developed based on DL. Image classification and categorization are performed using support vector machines (SVMs). These models separate data using hyperplanes in two or more dimensions. After employing Kernel parameters, an “optimal” hyperplane is determined, which creates “boundaries” for data categorization (Figure 3).27,28 Following categorization, DL algorithms are used to create artificial neural networks.27,29

Figure 3. Support vector machines (SVM) for data classification

Currently, AI models for capsule endoscopy include capsule tracking, detection of polyps, bleeding, ulcers, and the study of small intestine-specific pathologies like celiac disease and Crohn’s disease.26

In the gastrointestinal tract, models incorporated in capsule endoscopy usually allow for its tracking and localization in different segments (mouth, stomach, small intestine, and colon), after excluding frames with “noise” (feces, bubbles, etc.), with a sensitivity and specificity of 88.0%.30 Evaluating images based on their topographic location saves study time and enhances diagnostic accuracy.30